自动驾驶迎来编程难题 “出事了,撞谁”

文章导读

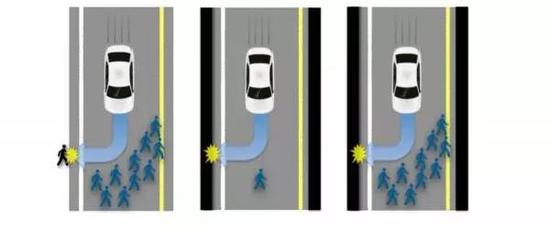

哲学领域内有一个道德问题,“电车难题”。如果你必须推一个人到行进中的有轨电车前面,以拯救轨道上的一群人,你会这么做吗?这个抽象概念也被带入了无人驾驶汽车的编程中:如果无法避免所有人怎么办?

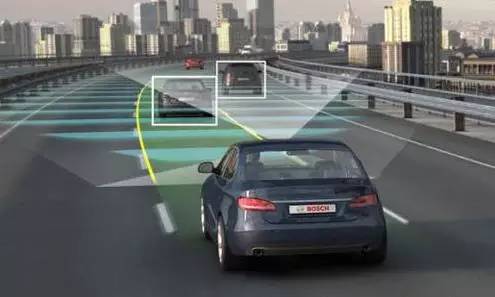

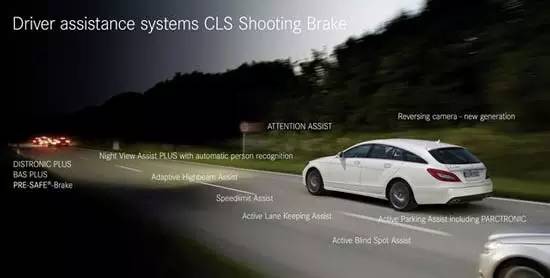

自动驾驶汽车能使我们更加安全,因为人类是最危险的驾驶者。但是,当我们交出了控制权,把汽车变成智能机器人之后,是否就可以高枕无忧了呢?事情恐怕没有那么简单。当不可避免的事故即将发生,自动驾驶汽车应该做出怎样的选择?为了让伤亡最小化,它应该牺牲车里的乘客,还是尽全力保护他们?或者说,在这种极端情况下,它应该做出随机的选择?

考虑一个这样的困境:在不久的将来,你拥有了一辆自动驾驶汽车。某天,在行驶过程中,某个不幸事件导致汽车冲向10个路人。汽车无法及时停下来,但是,它可以转向旁边的墙壁,而这或许会导致你的死亡。它应该怎么做?

图卢兹经济学院的研究人员决定看一下公众的决定,于是在网络问卷中设置了一系列的问题,其中一个情景是:汽车要么会杀死10个人以拯救司机,要么会转弯杀死司机以拯救那群人。结果他们发现超过75%的人支持牺牲路人以拯救个人,而在仅拯救1个人的情况下,约50%的人支持自我牺牲。然而调查对象并未真的想到真实汽车最终会以这种方式进行编程,同时他们也很可能不惜一切代价拯救车上的乘客。

该问卷由亚马逊土耳其机器人上的付费参与者回答,共有913人进行了不同问题的三项调查。由于这是一项网络调查,因此参与者可能来自世界各地。

第一个版本对司机不转弯时所杀死的人数进行了随机处理(从1至10),并询问车子应该牺牲乘客还是路人。第二个版本测试人们会如何自行对车子进行编程——总是牺牲乘客、总是保护乘客、或随机,并且要求他们对每一项的道德程度进行评价。第三个版本的参与者首先阅读了一个故事,故事中有10个人因为车子转向杀死乘客而获救。随后,他们被要求把自己想象成乘客、路人,并对道德进行评价。

研究结果是,通常情况下人们赞同这样的观点:从设计上,自动驾驶汽车应该使死亡人数最小化。如果自动驾驶汽车在现实中如此设计,那么销量一定很惨淡。原因是,人们都希望其他人坐在利人主义的自动驾驶汽车中,而自己不会购买这样的自动驾驶汽车。

又譬如,为了避开突然出现的摩托车,自动驾驶汽车转向墙壁或是悬崖,这是否可以接受?因为,一旦发生碰撞,汽车上乘客生还的可能性更大。但是当孩子在车上的时候,是否应该有不同的决策?因为,孩子们能够生活更长的时间。还有,如果汽车制造商提供了不同版本的道德算法,而且消费者有意选择了其中一种,那么,买家是否应该为计算机决策的后果负责呢?

毫无疑问,这个问题将折磨着自动化车辆产业,即便是在它们进行大规模生产之后。的确,无人驾驶的车辆能够减少90%的交通致死率;但正如同道德领域本身,剩下那10%究竟应如何处置仍旧有待商榷。对待无人驾驶汽车的发展,很多专家都表示乐观。但当技术问题转为道德问题,这将是一个很难攻克的难题。

免责声明:

本文仅代表作者/企业观点,与【风尚中国】无关。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,仅供读者参考,并自行核实相关内容。

【风尚中国】刊载此文出于传递更多信息之目的,并不意味着赞同其观点或证实其描述,也不代表本网对其真实性负责。

如因作品内容、版权和其它问题需要同本网联系的,请在30日内进行;新闻纠错: edit#fengsung.com